Can it be so that Judges aren’t allowing the USA to Deport Criminals, including Murderers, out of our Country and back to where they came from? If this is so, our Country, as we know it, is finished! Americans will have to get used to a very different, crime filled, LIFE. This is not what our Founders had in mind!!!

Может ли быть так, что судьи не разрешают США депортировать преступников, включая убийц, из нашей страны и обратно туда, откуда они приехали? Если это так, то нашей стране, какой мы ее знаем, пришел конец! Американцам придется привыкать к совсем другой, наполненной преступлениями ЖИЗНИ. Это не то, что имели в виду наши Основатели!!!

Сегодня прочитал такую новость (ниже цитата):

«Цукерберг решил прикончить СММ-агентства.

В интервью для Stratechery он прямо заявил: в будущем бизнесу не потребуется ни креатив, ни таргетинг, ни аналитика. Новая модель ведения рекламы в соцсетях по Цукербергу:

– AI сам создаёт фото и видео продуктов

– AI пишет тексты

– AI таргетирует

– AI замеряет результаты.

И всё это — на его платформах».

Обращаюсь к СММ-щикам и digital-маркетологам — переходите в Базир прямо сейчас, помогайте мне тут создавать движуху, завлекайте публику. Искусственным интеллектом я вас заменять не планирую. Я держу курс на живость интернета и минимизацию ИИ-контента. Моя цель — сохранить свободное и живое интернет-пространство, которое крупные корпорации сейчас стараются убить.

Астрономические часы

Здание Национального банка страны украшают астрономические часы – настоящее произведение искусства. На концах стрелок разместились луна и солнце. Каждый час часы отбивают мелодию. Устройство «многослойное», так как имеет несколько функций. По ним можно определить не только время, но и фазы луны, положение солнца, горизонт и меридиан. Циферблат часов подсвечиваются специальным образом.

Доля офіцера важка і непередбачувана. Не кожному вона під силу. Але саме вона розставляє правильних людей на життєвому шляху.

Дякую за науку і службу. Пишаюся нашим знайомством і дружбою.

З Днем Народження, Сергію Івановичу!

🧠 НОВОЕ "RAWDOGGING"? РАБОТНИКИ «BAREBACK’ЯТ» ПО ДОРОГЕ В ОФИС — И ЭТО БЕСИТ ПОПУТЧИКОВ

Абсолютное бездействие — новая горячая тенденция среди работников поколения Z?

Явление под названием «rawdogging», похоже, ушло в подполье, уступив место новой странной привычке молодых профессионалов, ездящих в метро: они уставляются на попутчиков, вместо того чтобы смотреть в телефон или читать книгу. Это якобы форма бунта против политики возвращения в офис.

Необычное поведение, получившее интригующее название «barebacking» (в оригинале термин с сексуальной окраской), предполагает полный отказ от гаджетов. Человек либо смотрит в пустоту, либо — что ещё хуже — устанавливает многократный, неловкий зрительный контакт с другими пассажирами, словно некий подземный серийный убийца, пишет Fortune.

🎙️ Подкастер Кёртис Мортон, придумавший термин, недавно раскритиковал таких «бездеятельных» попутчиков в видео на TikTok, набравшем 100 000 просмотров:

«Ты уже тысячу раз ездил на метро», — возмущается он. — «Почему ты сидишь без телефона, без книги, просто глазеешь на меня, на всех вокруг? Ну сделай хоть что-то!»

🚇 «Barebacking» — это метро-версия «rawdogging»

Эксперты считают, что с возвращением на работу после пандемии практика barebacking становится всё более популярной. Она похожа на другое странное поведение зумеров — «rawdogging» авиаперелётов, когда пассажиры отказываются от книг, фильмов, еды, воды и даже сна во время полёта, подобно аскетам в небе.

Как и в случае с «masterdating» (свидание с самим собой) или «girl dinners» (обед из случайных мелочей), это поведение носит показной характер. По сути, зумеры «изобрели» то, что существовало задолго до смартфонов — просто ездить в метро и ничего не делать.

😤 Бунт против контроля и культа продуктивности

Тем не менее, эксперты полагают, что рост популярности barebacking может быть способом дать отпор требовательным начальникам. После пандемии возможность работать из дома снова стала роскошью.

«Работники должны “включаться” в работу, когда приходят в офис, а не с момента посадки в поезд», — сказала Аманда Огастин, карьерный коуч в Resume.io.

По её словам, отвлечённость в метро помогает вернуть себе ценное личное время.

Так называемые «метро-каникулы» позволяют не проверять рабочие письма до начала рабочего дня.

Психотерапевт Элоиз Скиннер добавляет, что это может быть способ сохранить автономию и контроль над своим расписанием — ведь именно поездка на работу становится границей между «я-дома» и «я-на-работе».

🧘 Barebacking как психологическая защита

По мнению Скиннер, демонстративное ничегонеделание может быть формой психологического сопротивления всё более навязчивому культу продуктивности, особенно в контексте массовых увольнений и давления возврата в офис.

Однако Огастин считает, что barebacking может быть и просто способом перезагрузиться перед напряжённым офисным днём, полным экранов и цифрового шума.

«Переход назад в офис — трудный период для многих», — говорит она.

«Так что неудивительно, что некоторые предпочитают использовать дорогу, чтобы морально подготовиться или расслабиться, а не бессмысленно листать соцсети».

💡 Пауза без гаджетов полезна

В отличие от rawdogging в самолётах — которое может привести к обезвоживанию, тромбам и даже смерти, если неподвижно сидеть без воды часами — 40-минутная тишина в метро может быть даже полезна.

«Хотя сегодня это выглядит странно — просто уставиться в окно во время поездки — это, безусловно, огромная польза для психики», — говорит Тамаш Бокор, доцент Корвинского университета в Будапеште.

Он называет такое состояние «бодрствующей праздностью» и считает его «лучшей защитой от перегрузки информацией», так как оно даёт время упорядочить мысли, а не загружать себя новой информацией.

📉 Соцсети вредят психике — barebacking помогает

Barebacking предлагает заслуженную передышку от соцсетей, которые, как известно, негативно влияют на психическое здоровье.

Опрос 2 000 представителей Gen Z, проведённый в августе, показал:

- Почти половина страдают от тревожности или депрессии

- Эти состояния начинаются в среднем через 38 минут после начала скроллинга

Причины: тревожный контент, чувство бесполезно потраченного времени, FOMO (страх что-то упустить)

⚠️ Bareback — но в меру

Эксперты предупреждают: даже ничегонеделание должно быть в меру.

«Если человек каждый день “отключается” в пути и совсем не использует это время на планирование дня или общение, он может стать рассеянным и отставать от задач в офисе», — предостерегает Огастин.

Другие специалисты советуют: barebacking должен быть перезагрузкой, а не способом бегства от проблем.

«Вопрос в том: я в моменте, и помогаю ли я своему разуму восстановиться?» — говорит Куссай Эль-Чичакли, коуч WU Executive Academy в Вене.

«Или я избегаю мыслей о работе, что может наоборот отнимать силы и указывать на более глубокие, неразрешённые конфликты?»

25 ТЫСЯЧ ЖИТЕЛЕЙ ТУРЕЦКОГО ГОРОДА ЛИДЖЕ НЕОЖИДАННО «НАКУРИЛИСЬ» МАРИХУАНОЙ.

Местная полиция решила показательно сжечь 20 тонн травы после ареста крупного наркоторговца, но неудачно выбрала место.

В результате «дымок» охватил весь город, жители ощущали эффект целых пять дней, однако жаловаться не стали.

I am pleased to announce that I will be nominating Anthony Lomangino to join the United States Postal Service Board of Governors. Anthony is a fantastic businessman and reformer, who built one of the most successful sanitation businesses in the Country. He knows how to fix a problem, and the Postal Service has many! I know he will serve with great distinction. Congratulations Anthony!

Я рад объявить, что я выдвину кандидатуру Энтони Ломангино на должность члена Совета управляющих Почтовой службы США. Энтони — фантастический бизнесмен и реформатор, который построил один из самых успешных санитарных предприятий в стране. Он знает, как решить проблему, а у Почтовой службы их много! Я знаю, что он будет служить с большим отличием. Поздравляю, Энтони!

ОТВЕЧАЮ НА ВОПРОС: ОТКУДА СЛОВО СУДЬБА

Оно образовано от корня корня «суд». «Суд» — это изначально рассмотрение дела, решение, приговор. Корень «суд» происходит от праславянского *sǫdъ, восходящего к праиндоевропейскому корню *sed- — «сидеть». Почему «сидеть»?

В древности судья буквально садился на специальное место (седалище, трон) и оттуда выносил решения. Отсюда же слова «седалище», «судить», «посад» (населённый пункт, где "сидят" люди), «ассистент» (лат. assidere — сидеть рядом).

Изначально судьба — это был буквально судебный приговор, решение.

Позже слово стало означать решение свыше, неотвратимое развитие событий, нечто предначертанное. От юридического смысла перешли к философско-религиозному.

Таким образом, судьба — это то, что решено, установлено кем-то выше (судьёй, Богом, силами мира). Иными словами, судьба в древнем понимании — это приговор, постановление, которому человек должен следовать.

®️ Викисловарь + Понятие "судьба" в современном русском языке (на основе анализа анкет преподавателей и студентов Южно-Уральского государственного университета)

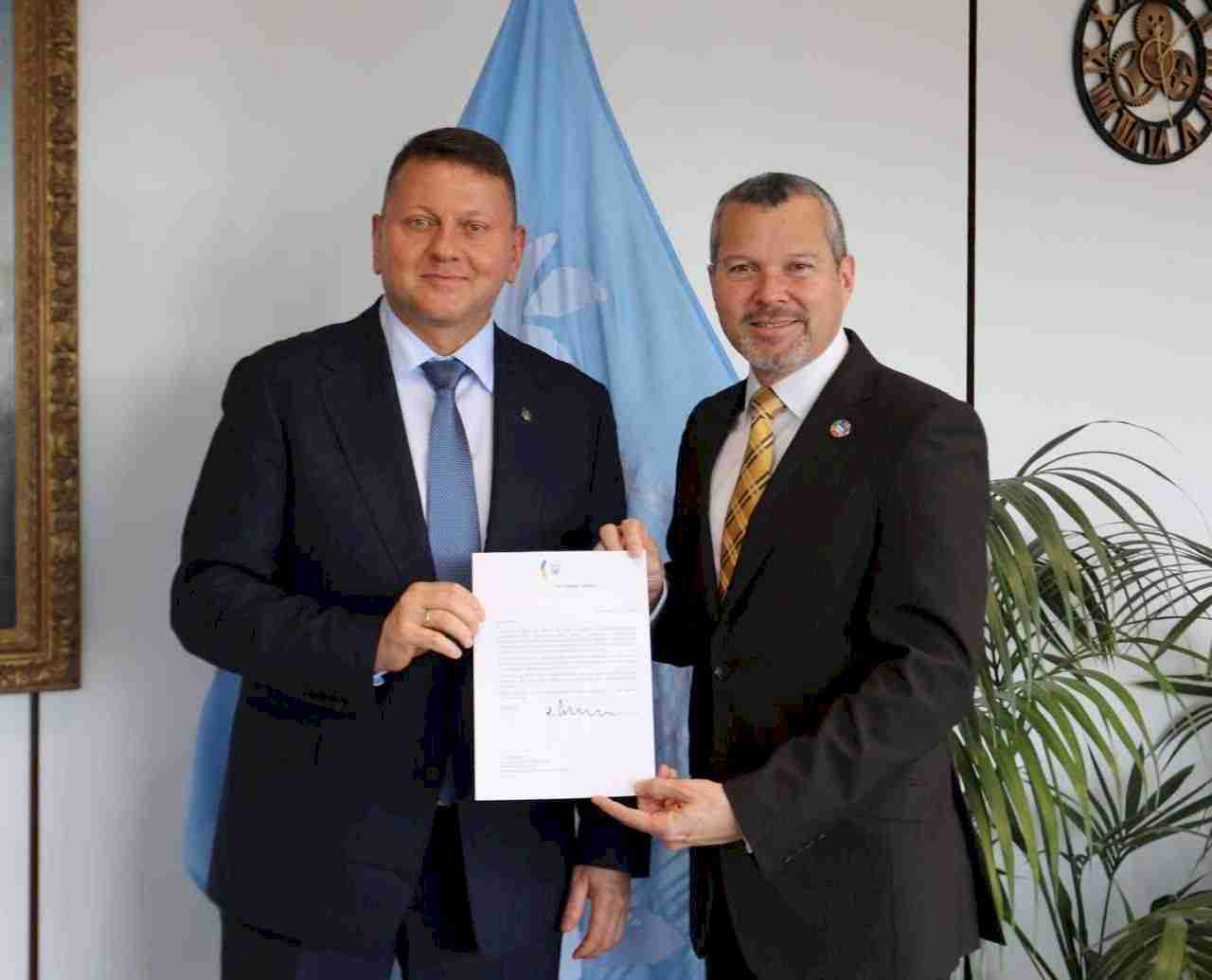

Вручив вірчі грамоти Генсеку Міжнародної морської організації Арсеніо Домінгесу. Поговорили про співпрацю, боротьбу з "тіньовим флотом" та потреби України для розвитку морського потенціалу.

Україна - морська держава. І ми тримаємо цей курс, навіть у шторм.

🛍️ ТЕПЕРЬ CHATGPT МОЖЕТ ДЕЛАТЬ ПОКУПКИ ЗА ВАС

OpenAI объявила в понедельник, что пользователи скоро смогут делать покупки через ChatGPT, что составит конкуренцию Google Shopping.

Кнопки для покупок на основе поиска с помощью ИИ будут постепенно становиться доступными для всех, у кого установлен чат-бот, включая гостей без аккаунта.

🧠 Что говорят в OpenAI

Адам Фрай, руководитель продукта поиска в ChatGPT, рассказал изданию WIRED, что люди уже активно используют инструмент для поиска самых разных товаров в различных категориях — например, в сфере красоты, товаров для дома и электроники.

Добавление возможности делать покупки прямо в сервисе упростит процесс для покупателей.

🛒 Но оформить покупку внутри ChatGPT нельзя

Пользователи не смогут завершить покупку внутри ChatGPT.

Вместо этого их будут перенаправлять на сайт продавца для оформления заказа и завершения транзакции.

📋 Как будут выглядеть рекомендации

Чат-бот будет генерировать подобранный список товаров и объяснять, почему именно эти варианты выбраны.

Рекомендации будут основаны на:

данных о предпочтениях пользователя, которые ChatGPT запомнил,

отзывах о товарах из интернета.

Таким образом, AI будет подбирать продукты, которые, по его мнению, максимально соответствуют вкусам и потребностям пользователя.

🌐 Откуда ChatGPT будет брать отзывы

Источники включают:

редакционные обзоры товаров,

обсуждения на форумах, таких как Reddit.

«Он не ищет определённые сигналы, встроенные в какой-то алгоритм», — пояснил Фрай.

«Он пытается понять, как люди обсуждают этот товар, какие плюсы и минусы они находят.»

🔎 Как это будет отличаться от Google Shopping

Фрай отметил, что опыт покупок через ChatGPT будет более персонализированным и похожим на беседу, в отличие от привычного поиска по ключевым словам, как в Google Shopping.

Хотя новая функция во многом напоминает Google Shopping (например, после выбора товара справа появится список продавцов с кнопками покупки), главное отличие — в ChatGPT результаты органические, а не рекламные.

«Это не реклама», — подчеркнул Фрай.

«Это не спонсорские материалы.»

📑 Как будет выглядеть процесс покупки

Опции покупки будут появляться в вкладке справа на экране.

Пользователь сможет просто задать ChatGPT вопрос — например:

«Какая кофемашина лучше за 200 долларов для маленькой кухни?»

Чат-бот предложит список лучших вариантов. При клике на товар справа появятся предложения о покупке. Нажав кнопку "Купить", пользователь перейдёт на сайт продавца для оформления заказа.

The USA lost Billions of Dollars A DAY in International Trade under Sleepy Joe Biden. I have now stemmed that tide, and will be making a fortune, very soon. Stay tuned as we MAKE AMERICA GREAT AGAIN!!!

США теряли миллиарды долларов в день в международной торговле при Сонном Джо Байдене. Теперь я остановил эту волну и очень скоро заработаю состояние. Оставайтесь с нами, пока мы СНОВА ДЕЛАЕМ АМЕРИКУ ВЕЛИКОЙ!!!

Крепость Нарикала

Первые упоминания о крепости относятся к V веку. С VII века она была не раз завоевана византийцами, монголами, а затем арабами. Достаточно долго Нарикала являлась центром Грузинского царства. Мощное укрепление возвышается на вершине холма в окружении отвесных скал, что серьезно затрудняло доступ врагу во время осады. В 1827 году в результате мощного землетрясения сооружение серьезно пострадало. Частичная реставрация было проведена в 90-е гг. XX века.

ОТВЕЧАЮ НА ВОПРОС: СЛОВО ВЫЖИТЬ

Приставка вы- обычно означает выход наружу, завершение процесса, либо выход из процесса:

Бросить — выбросить;

Быть — выбыть;

Идти — выйти;

Пить — выпить;

Спать — выспаться.

Жить — выж...

Постойте, слово «выжить» означает сохранить жизнь, а не окончить её. Почему же так происходит? Дело в том, что исторически у приставки «ВЫ-» сохранился ещё один смысл — преодоление:

Нести — вынести;

Держать — выдержать;

Стоять — выстоять;

В старославянском языке слово «выбыти» (эквивалент совр. «выбыть») означало пережить кого-то, продержавшись дольше него. Таким образом и ВЫЖИТЬ означает продержаться в опасной рискованной для жизни ситуации.

Однако всё-таки «выжить» может употребляться и в противоположном значении:

— выжить из ума;

— выжить из квартиры кого-то.

Сама приставка «ВЫ» родственна другим приставкам индоевропейских языков:

— готскому и древнеисландскому út — «из»,;

— древнеиндийскому и древнеперсидскому ud- «на, вверх, из»;

авестийскому us-, uz-,

®️ Викисловарь.

Нам нужно мужественное ПРАВОСУДИЕ в нашей стране. Если суды не разрешат то, что нам позволяли делать в течение 250 лет, Америка больше не сможет быть прежней. Мошенник Джо Байден уничтожит нашу страну своим БЕЗУМИЕМ открытых границ и позволит преступникам всех типов въезжать без какого-либо возмездия. Убийцы, наркоторговцы, члены банд и даже психически ненормальные поселятся в нашей стране, сея хаос, которого мы никогда не видели раньше. Невозможно устроить суды над миллионами и миллионами людей. Мы знаем, кто преступники, и мы должны вывезти их из США ¬— и БЫСТРО!

We need Courageous JUSTICE in our Country. If the Courts don’t allow what we have been allowed to do for 250 years, America can no longer be the same. Crooked Joe Biden will have destroyed our Country with his Open Border MADNESS, and allowing criminals of every type to enter with no Retribution. Murderers, Drug Dealers, Gang Members, and even the Mentally Insane will make their home in our Country, wreaking havoc like we have never seen before. It is not possible to have trials for millions and millions of people. We know who the Criminals are, and we must get them out of the U.S.A. ¬— and FAST!

Позже сегодня я встречусь, из всех людей, с Джеффри Голдбергом, редактором The Atlantic, и человеком, ответственным за множество вымышленных историй обо мне, включая выдуманную МИСТИФИКАЦИЮ о «лохах и неудачниках» и SignalGate, с чем он был несколько более «успешным». Джеффри приводит с собой Майкла Шерера и Эшли Паркер, которые тоже не совсем протрамповские писатели, мягко говоря! Они сказали моим представителям, что история, которую они пишут, будет называться «Самый значимый президент этого столетия». Я даю это интервью из любопытства и в качестве соревнования с самим собой, просто чтобы посмотреть, может ли The Atlantic быть «правдивым». Способны ли они написать честную историю о «ТРАМПЕ»? С моей точки зрения, что может быть такого плохого — Я ПОБЕДИЛ!

Later today I will be meeting with, of all people, Jeffrey Goldberg, the Editor of The Atlantic, and the person responsible for many fictional stories about me, including the made-up HOAX on “Suckers and Losers” and, SignalGate, something he was somewhat more “successful” with. Jeffrey is bringing with him Michael Scherer and Ashley Parker, not exactly pro-Trump writers, either, to put it mildly! The story they are writing, they have told my representatives, will be entitled, “The Most Consequential President of this Century.” I am doing this interview out of curiosity, and as a competition with myself, just to see if it’s possible for The Atlantic to be “truthful.” Are they capable of writing a fair story on “TRUMP”? The way I look at it, what can be so bad – I WON!